تحلیل داده چیست؟ – از کاربرد تا اهمیت و انواع به زبان ساده

در عصر حاضر که سرشار از دادههای گوناگون است، درک چگونگی تحلیل و استخراجِ معنای صحیح، از بینشهای دیجیتالی کسب و کارها، یکی از عوامل اصلی موفقیت، محسوب میشود. «تحلیلِ داده» (Data Analysis)، فرایندی است شامل سازماندهی، پاکسازی و بررسی دادههای خام که به منظور حصول نتیجهای مؤثر، مورد استفاده قرار میگیرد و کشف راهحلهایی معنادار را بهدنبال دارد. بهطور خلاصه، تحلیل داده در مورد معنا بخشیدن به دادهها، برای کمک به اتخاد تصمیمهای آگاهانه و کاربردی است. تحلیل داده به ما کمک میکند تا پاسخ پرسشهایمان را بیابیم، فرضیههایمان را آزمایش و نظریههای موجود را رد کنیم. در این مطلب از مجله تم آف، با تشریح ماهیت علم «تحلیل داده» و اهمیت آن، تا حد زیادی، پاسخ به این پرسش که «تحلیل داده چیست» را، پوشش میدهیم.

امروزه بسیاری از شرکتها بهطور منظم، مقادیر گستردهای از «داده» را جمعآوری میکنند. با این وجود، دادهها در حالت اولیه خود، معنا و ارزش خاصی ندارند. اینجاست که تحلیل دادهها، نقش مهمی را ایفا میکند. تجزیه و تحلیل داده، شامل بررسی دادههای خام برای کشف بینشهای مهم و مفید است. از بینشهای بهدست آمده، که اطلاعات ارزشمندی محسوب میشوند، میتوان در «انتخابها» و تصمیمهای تجاریِ هوشمندانه، استفاده کرد.

تحلیل داده چیست ؟

«تحلیل داده»، فرایندی است متشکل از گامهایِ «بررسی» (Inspecting)، تمیز کردن یا «پاکسازی» (Cleansing)، «تبدیل» (Transforming) و «مدلسازیِ» (Modeling) دادهها که با هدف کشف و استخراج اطلاعات مفید از آنها و کمک به فرایند تصمیمگیری، مورد استفاده قرار میگیرد.

تحلیل داده، جنبهها و رویکردهای متعددی دارد و تکنیکهای گوناگونی را تحت نامهای مختلف در بر میگیرد. «Data Analysis» در حوزههای وسیعی نظیر تجارت، علوم اجتماعی و بسیاری از موارد دیگر استفاده میشود. در دنیای کنونیِ کسب و کار، تحلیل داده، نقشی مهمی را در فرایند تصمیمگیریِ علمیتر و کمک به کسبوکارها، برای اینکه عملکرد مؤثرتری داشته باشند، ایفا میکند.

فرایند تحلیل داده چیست ؟

«تحلیل»، به معنای تقسیم «کل» به مؤلفههای سازنده آن، به منظور بررسی هر «جزء» است. تحلیل داده، فرایندی را دنبال میکند که طی آن، دادههای خام، جمعآوری و بهدنبال آن، به اطلاعات مفید و ارزشمندی تبدیل میشوند و به کاربران، در فرایند تصمیمگیری کمک میکنند. به بیان سادهتر، دادهها جمعآوری و تحلیل میشوند با این هدف که پاسخی باشند برای پرسشها، فرضیههایی را آزمایش، یا اینکه نظریهای را رد کنند.

آقای «جان توکی»، ریاضیدان و آماردان امریکایی، که برای توسعه الگوریتم «تبدیل فوریه سریع» شناخته شده است، در سال ۱۳۴۰ (۱۹۶۱ میلادی)، تحلیل داده را بهصورتی تعریف کرد که در ادامه آمده است:

«رویههایی که داده را تحلیل و تکنیکهایی که نتایج این رویهها را تفسیر میکنند؛ روشهایی برای برنامهریزیِ نحوه جمعآوری دادهها، بهگونهای که برای تحلیل، آسانتر، دقیقتر و صحیحتر باشند و همچنین، تمام ابزارها و نتایج حاصل از مباحث ریاضی (و آمار) که برای تحلیل کردن دادهها بهکار برده میشود.»

مراحل مختلفی در تحلیلِ داده وجود دارد که، در ادامه این مطلب، به شرح هر یک از آنها پرداخته شده است. نکته قابل توجه این است که مراحلِ تحلیل داده، «تکرار شونده» (Iterative) هستند، چون بازخوردی که از مراحل بعدی بهدست میآید، ممکن است منجر به این شود که عملیات بیشتری را در مراحل پیشین انجام دهیم. فریمورک «CRISP» که در دادهکاوی مورد استفاده قرار میگیرد، از مراحلی این چنینی، پیروی میکند.

انواع تحلیل داده چیست ؟

«دادهکاوی» (Data Mining)، روشی خاص از تحلیل داده است که بر مدلسازی آماری و کشف دانش برای اهداف «پیشگویانه» و نه صرفاً «توصیفی» (Descriptive) تمرکز دارد. در حالیکه «هوش تجاری» (Business Intelligence)، تحلیل دادهای را پوشش میدهد که به شدت بر «انباشتگی» (Aggregation)، متکی است و تمرکز آن عمدتاً بر روی اطلاعات مربوط به کسب و کار است.

در کاربردهای آماری، تحلیل داده را میتوان به آمار «توصیفی» (Descriptive)، «تحلیل داده اکتشافی» (Exploratory Data Analysis | EDA) و «تحلیل داده تاییدی» (Confirmatory Data Analysis | CDA) تقسیم کرد. «EDA» در دادهها به دنبال ویژگیهای جدید میگردد، در حالیکه «CDA» بررسی میکند که آیا فرضیههای موجود، صحیح هستند یا خیر.

«تحلیل پیشگویانه» (Predictive Analytics) بر کاربردِ مدلهای آماری به منظور پیشبینی یا «طبقهبندی» (Classification) تمرکز دارد، درحالیکه متنکاوی یا «تحلیل متن» (Text Analytics) از تکنیکهای آماری، زبانی و ساختاری برای استخراج و طبقهبندی اطلاعات از منابع متنی (نوعی از دادههای بدون ساختار)، استفاده میکند.

تمام مواردی که تا اینجا به آنها اشاره کردیم، در حقیقت، انواع مختلفی از تحلیل داده هستند. «یکپارچهسازی دادهها» (Data Integration) به عنوان نقطه شروعی برای تحلیل دادهها محسوب میشود. «مصورسازی داده» (Data Visualization) و به اشتراکگذاری آن نیز ارتباط نزدیکی با «تحلیل داده» دارد.

«یکپارچهسازی دادهها»، شامل ترکیبِ دادههای موجود در منابع مختلف و ارائه نمایی یکپارچه از آنها به کاربران است. از جمله حوزههایی که این فرایند، در آنها اهمیت پیدا میکند و نیاز به تحلیل داده، در آنها حس میشود، میتوان به حوزههای تجاری (مانند زمانی که دو شرکتِ شبیه به هم، نیاز به ادغام پایگاه دادههای خود دارند) و حوزه علمی (به عنوان مثال ترکیب نتایج تحقیقات از مخازن مختلف بیوانفورماتیک) اشاره کرد. با افزایش حجم دادهها، مفهوم «کلان داده» (Big Data) مطرح میشود و نیاز به اشتراکگذاری دادههای موجود، عملیات «یکپارچهسازی»، بهطور وسیعی مورد استفاده قرار میگیرد.

مطالعات بسیاری در این زمینه انجام شده است، با این وجود، هنوز هم شاهد مسائل حل نشده زیادی در این حوزه هستیم. یکپارچهسازی دادهها، به کاربران داخلی و خارجی کمک میکند تا با یکدیگر همکاری داشته باشند. دادههایی که یکپارچه میشوند، باید از «سیستم پایگاه داده ناهمگنی» (Heterogeneous Database System) دریافت و به «دیتای ذخیره شده منسجمی» تبدیل شوند که دادههای «همزمان» را در سراسرِ شبکهای از فایلها، برای مشتریان فراهم میکند. یکی از کاربردهای رایج یکپارچهسازی دادهها، در حوزه دادهکاوی و در هنگامِ تحلیل و استخراج اطلاعات از پایگاههای داده موجود است که میتواند برای اطلاعات کسب و کار سودمند واقع شود.

گفتیم که یکپارچهسازی دادهها میتواند به کاربران کمک کند تا در داخل و خارج از سازمان بهتر با یکدیگر همکاری کنند. برای انجام این کار، ابتدا باید دادهها را از منابع مختلف جمعآوری و سپس به قالبی ثابت تبدیل کرد تا به سهولت در دسترس کسانی قرار گیرد که به آن نیاز دارند.

«پاکسازی دادهها» (Data Cleaning یا Data Cleansing)، فرایند شناسایی و تصحیح (یا حذف) سوابق ناسالم از «مجموعه رکورد» (Record Set)، «جدول» (Table) یا «پایگاهداده» (Database) است و به کشف قسمتهای ناقص، نادرست، (به درد نخور) یا نامربوط از دادهها کمک میکند. همچنین در پاکسازی دادهها به جایگزینی، اصلاح، یا حذف دادههای کثیف یا ناهنجار پرداخته میشود.

تمیز کردن دادهها، ممکن است به صورت تعاملی و با ابزارهای «دادهورزی یا آمادهسازی داده» (Data Wrangling) یا «پردازش دستهای» (Batch Processing) از طریق نوشتن اسکریپت یا «فایروالِ کیفیت داده» (Data Quality Firewall) انجام شود. لازم به ذکر است که پس از انجام فرایندِ پاکسازی، «مجموعه داده» مورد نظر باید با سایر مجموعه دادههای مشابه در سیستم، سازگار باشد.

«تبدیل» (Transforming)، شامل فرایند تبدیل دادهها از فرمت یا ساختاری خاص، به فرمت یا شکل دیگری است و یکی از جنبههای اساسیِ یکپارچهسازی و کارهای مدیریت دادهها (مانند دادهورزی، انبار داده یا Data Warehouse، یکپارچهسازی دادهها و یکپارچهسازی برنامهها) محسوب میشود.

فرایند «تبدیل داده»، با توجه به تغییرات مورد نیازی که در دادهها (بین دادههای اولیه و دادههای نهایی) صورت میگیرد، میتواند ساده یا پیچیده باشد. این کار معمولاً از طریق ترکیبی از مراحل دستی و خودکار انجام میشود. ابزارها و فناوریهای مورد استفاده برای تبدیل دادهها بر اساس فرمت، ساختار، پیچیدگی و حجمِ دادههای در حال تبدیل، میتوانند بهطور گستردهای متفاوت باشند.

«مدلسازی دادهها» (Data Modeling) در مهندسینرم افزار، شامل فرایند ایجاد «مدل داده» برای سیستم اطلاعاتی، با اِعمال تکنیکهای قرارداردیِ مشخصی است. «مدل داده» تعیین میکند که داده به چه صورتی به کاربرِ نهایی ارائه شود.

هدف از مدلسازی، ایجاد و ساختاردهیِ بهینه جداولی از پایگاه داده است که بهترین پاسخ را برای پرسشهای کسب و کار، داشته باشد. همچنین کاربر نهایی را در معرض مرتبطترینِ دادهها قرار دهد و زمینه را برای تحلیل مناسبِ دادههای موجود، فراهم کند. انواع مختلفی از روشهای تحلیل داده وجود دارد که در ادامه برخی از معروفترین آنها را مرور میکنیم.

تحلیل متن در تحلیل داده چیست ؟

به «تحلیل متن» (Text Analysis)، «دادهکاوی» (Data Mining) نیز گفته میشود. این روش با استفاده از پایگاههایداده یا سایر ابزارهای دادهکاوی، «الگویی» (Pattern) را در «مجموعه دادههایِ» بزرگ کشف میکند.

تحلیل آماری در تحلیل داده چیست ؟

«تحلیل آماری» (Statistical Analysis)، با استفاده از دادههای پیشین در قالب داشبورد، به این پرسش که «چه چیزی رخ داده است»، پاسخ میدهد. این نوع تحلیل، شامل «جمعآوری» (Collection)، «تحلیل» (Analysis)، «تفسیر» (Interpretation)، «ارائه» (Presentation) و «مدلسازیِ» (Modeling) دادهها است.

تحلیل تشخیصی در تحلیل داده چیست ؟

«تحلیل تشخیصی» (Diagnostic Analysis)، با جستجوی علت، از بینشهای کشف شده در طول تحلیل آماری، به این پرسش پاسخ میدهد که «چرا این اتفاق افتاد». این نوع تحلیل برای شناسایی الگوهای رفتاری دادهها، مفید است.

تحلیل پیش گویانه در تحلیل داده چیست ؟

«تحلیل پیشگویانه» (Predictive Analysis)، بیانگر این است که با بهکارگیری دادههای پیشین چه اتفاقی رخ میدهد. در این تحلیل، بر مبنای دادهها، پیشبینیهایی درباره نتایجِ آینده انجام میشود.

تحلیل تجویزی در تحلیل داده چیست ؟

«تحلیل تجویزی» (Prescriptive Analysis)، آگاهیها و «بینشهایِ» (Insights) بهدست آمده از تحلیلهای متنی، آماری، تشخیصی و پیشگویانه را ترکیب میکند. هدف این است که اقداماتی تعیین شود تا راهحلی برای مشکل فعلی، یا تاثیری روی تصمیمات داشته باشد.

روشهای مختلفی که تا اینجا معرفی شد را بسته به نیازِ کسب و کار و فرایند تصمیمگیری میتوانیم باهم ترکیب کنیم. مثالی از ترافیک وب را در نظر بگیرید، که شرکت ما به احتمال زیاد آن را ردیابی میکند. ما موارد و معیارهایی که در رابطه با ترافیک وب جمعآوری شده است را در اختیار داریم که در ادامه بیان میشود.

- موقعیت

- فعالیت در هر زمان از روز

- موبایل یا PC بودن دستگاه

- مرورگرهای در حال استفاده

هر یک از نقاط دادهای، بخش کوچکی از تحلیل کلی محسوب میشود. بنابراین، تحلیلهای زیادی برای تعیین مواردی مانند نحوه بهینهسازی وبسایت، برای دستیابی به اهدافی که در نظر داریم، انجام میشود. در ادامه برخی از این موارد آورده شده است.

- بهبود فرصتهای فروش

- کاهش زمان فروش (زمانی که تا فروش طی میشود.)

- افزایش درآمد و سود

مفاهیم مختلف تحلیل داده چیست ؟

تحلیل داده، شامل بخشهای مختلفی میشود که در ادامه به آنها پرداخته شده است.

ملزومات داده ای در تحلیل داده به چه معناست؟

یکی از ضروریترین مراحل در فرایند «تحلیل داده»، دادههایی است که به عنوان ورودی دریافت میکنیم. دادههای ورودی، بر اساس نیازهای کسانی تعیین میشود که مسئولیت تحلیل را بر عهده دارند یا مشتریانی که از نتایجِ حاصل از تحلیل استفاده خواهند کرد.

نوع موجودیتی که داده بر اساس آن جمعآوری میشود، «واحد آزمایشی» (Experimental Unit) نامیده میشود (که به عنوان مثال، میتواند فرد یا جمعیتی از افراد باشد). متغیرهای خاصی در رابطه با جمعیت (به عنوان مثال، سن و درآمد) ممکن است مشخص شود و بهدست بیاید. همچنین، دادهها ممکن است عددی یا «دستهای» (Categorical) باشند (به عنوان مثال، برچسبی متنی برای اعداد باشند).

جمع آوری داده ها چیست؟

دادههایی که به منظور تحلیل، مورد استفاده قرار میگیرند را از منابع مختلفی میتوان جمعآوری کرد. فهرستی از منابع دادهای وجود دارد که میتوان برای مطالعه و تحقیق مورد استفاده قرار داد. تحلیلگران، ملزومات دادهای و مواردی که نیاز دارند را به متولیان دادهها (بهطور مثال کارکنان فناوری اطلاعات در یک سازمان)، ابلاغ میکنند.

دادهها ممکن است از حسگرهای موجود در محیط، از جمله دوربینهای ترافیکی، ماهوارهها، دستگاههای ضبط و غیره جمعآوری شوند. همچنین ممکن است از طریق مصاحبه، دانلود از منابع اینترنتی، یا مطالعه اسناد موجود بهدست آیند.

پردازش داده ها به چه معناست؟

به منظور تحلیل داده، لازم است که دادههای بهدست آمده را ابتدا سازماندهی کنیم. برای نمونه، این کار را میتوان با قرار دادن دادهها در سطرها و ستونها (در قالب جدول، که با نام دادههای ساختاریافته معروف است) انجام داد. استفاده از «صفحهگسترده» (Spreadsheet) یا نرمافزارهای آماری نیز برای تحلیل، معمولاً رایج است.

پاک سازی داده ها چیست؟

پس از انجام پردازش و سازماندهی، دادهها ممکن است ناقص، حاوی موارد تکراری یا خطاهایی باشند. نیاز به پاکسازی دادهها، از نحوه ورود و ذخیره آنها ناشی میشود و پاکسازی دادهها فرایندی است که برای جلوگیری و اصلاح این خطاها صورت میگیرد.

از کارهای متداولی که در این زمینه انجام میشود، میتوان به تطبیق رکورد، شناسایی نادرستی دادهها، کیفیت کلی دادههای موجود، حذف دادههای تکراری و تقسیمبندی ستونها، اشاره کرد. مشکلات دادهای این چنینی را میتوان با استفاده از انواع تکنیکهای تحلیلی نیز تشخیص داد. بهطور مثال در مورد اطلاعات مالی، مجموعِ متغیرهای خاص ممکن است با اعداد منتشر شده جداگانهای (که قابل اعتماد هستند) مقایسه شوند.

مقادیر غیرمعمول، بالاتر یا پایینتر از آستانههای از پیش تعیین شده نیز ممکن است بررسی شوند. انواع مختلفی از پاکسازی دادهها (بسته به نوع دادههای موجود در مجموعه داده) وجود دارد. این دادهها میتوانند شماره تلفن، آدرسِ ایمیل، اطلاعات مربوط به کارفرمایان، یا سایر مقادیر باشند.

استفاده از روشهای داده «کمّی» (Quantitative) برای تشخیص موارد پَرت و همچنین خلاص شدن از شرّ دادههایی که به نظر میرسد (احتمالا) به اشتباه وارد شدهاند، ممکن است مفید واقع شوند. میتوان از «تصحیح کننده املا» (Spell Checkers)، در رابطه با دادههای متنی، استفاده کرد تا از این طریق، تعداد کلماتی که اشتباه تایپی دارند را کاهش دهیم. با این حال، تشخیص اینکه خودِ کلمات صحیح هستند یا خیر، میتواند دشوار باشد.

تحلیل اکتشافی داده ها در تحلیل داده چگونه است؟

پس از پاکسازی و تمیز شدن مجموعهداده، میتوان آن را تحلیل کرد. تحلیلگران برای این کار از روشهای مختلفی که به «تحلیل اکتشافی دادهها» (Exploratory Data Analysis)، شناخته میشوند، برای درک پیام موجود در دادهها استفاده میکنند. فرایند کاوش در دادهها ممکن است منجر به پاکسازیِ بیشتر دادهها یا درخواستی برای دادههای بیشتر را بهدنبال داشته باشد.

«آمار توصیفی»، مانند میانگین یا میانه، میتواند برای کمک به درک دادهها بهکار گرفته شود. «مصورسازی دادهها» نیز تکنیکی است که با وجود آن، تحلیلگر میتواند دادهها را در قالبی گرافیکی بررسی کند تا بینشهای بیشتری در مورد پیامهای نهفته در آن، بهدست آورد.

منظور از مدل سازی و الگوریتم ها در تحلیل داده به چه معناست؟

فرمولهای ریاضی یا مدلها (که به عنوان الگوریتم شناخته میشوند)، ممکن است با هدف شناسایی روابط بین متغیرها، روی دادهها اعمال شوند. برای مثال، میتوان از مواردی نظیرِ «همبستگی» (Correlation) یا «علیت» (Causation) استفاده کرد. به بیان ساده، میتوان مدلهایی را انتخاب کرد که برای ارزیابی متغیری خاص، با استفاده از دادههای سایر متغیرهای مجموعه داده، مورد استفاده قرار گیرند. با توجه به «دقتِ» (Accuracy) مدل پیادهسازی شده، ممکن است خطاهایی (از نوع Residual Error) را شاهد باشیم.

«استنباط آماری» (Statistical Inference)، استفاده از تکنیکهایی را شامل میشود که روابط بین متغیرهایی خاص را اندازهگیری میکند. برای مثال، «تحلیل رگرسیونی»، ممکن است برای مدلسازی این مورد استفاده شود که آیا تغییر در «تبلیغات» (متغیر مستقل X)، میتواند تغییر در فروش (متغیر وابسته Y)، یعنی افزایش یا کاهش آن را بیان کند یا خیر. تحلیلگران همچنین ممکن است با هدفِ سادهسازی فرایند تحلیل و انتقال نتایج آن، سعی کنند مدلهایی بسازند که توصیفی از دادهها باشند.

محصول داده در تحلیل داده چیست؟

در پاسخ به این پرسش که «محصول داده» (Data Product) چیست، باید بگوییم که، برنامهای کامپیوتری است که ورودیهای دادهای را میگیرد و اطلاعات مفید را به عنوان خروجی باز میگرداند. این برنامه ممکن است بر اساس مدل یا الگوریتم عمل کند. برای مثال، برنامهای را در نظر بگیرید که دادههای مربوط به «تاریخچه خرید مشتری» را تحلیل میکند و با توجه به نتایج حاصل، اقلام دیگری که ممکن است مورد پسند مشتری واقع شوند را به وی توصیه میکند.

منظور از ارتباط در تحلیل داده به چه معناست؟

پس از تحلیل دادهها، میتوان آن را در قالبهای گوناگون به کاربران گزارش کرد تا نیازهایشان برطرف شود. باتوجه به بازخورد کاربران ممکن است نیاز باشد تحلیل بیشتری انجام دهیم. بنابراین فرایند تحلیل، معمولاً تکرار همین چرخه است. زمانیکه قرار است نحوه انتقال نتایج تعیین شود، تحلیلگر میتواند پیادهسازی انواع تکنیکهای مصورسازی دادهها را به منظور کمک به انتقالِ واضحتر و کارآمدتر پیام به مخاطب، در نظر داشته باشد.

«مصورسازی دادهها» (Data visualization)، برای کمک به انتقال پیام کلیدی موجود در دادهها، از عناصر گرافیکی و مواردی همچون جداول و نمودارها، استفاده میکند. جداول، ابزار مفیدی بهشمار میروند و به کاربران، در انجام «پرسوجو» و تمرکز روی مقادیر عددی خاص، کمک میکنند. حال آنکه نمودارها (از جمله نمودار میلهای یا خطی)، میتوانند توضیحی برای پیامهای کمّی موجود در دادهها، داشته باشند.

روش های مورد استفاده در تحلیل داده چیست ؟

در این قسمت، محبوبترین روشهایی که تحلیلگران داده به آنها متکی هستند را بیان میکنیم.

تحلیل خوشه ای داده چیست؟

«تحلیل خوشهای» (Cluster Analysis) روشی برای تحلیل داده است که به موجب آن مجموعهای از اشیا یا نقاط داده که ویژگیهای مشابه دارند، با هم و در خوشههایی گروهبندی میشوند (یا به اصطلاح خوشهبندی میشوند). هدف از این نوع تحلیل، سازماندهی دادههای مشاهده شده، در ساختارهایی معنادار، با هدف سهولت در دستیابی به بینشِ بیشتر از آنها است.

تحلیل گروهی در تحلیل داده چیست؟

«تحلیل گروهی» (Cohort Analysis)، گونهای از تحلیل است که در آن، دادهها قبل از تحلیل (که معمولاً به افراد متصلاند)، به گروههایی مرتبط بههم تقسیم میشوند. این گروهها (یا Cohortها)، ویژگیها و تجربیات مشترکی را به اشتراک خواهند گذاشت.

تحلیل Cohort، این امکان را برای کسبوکارها فراهم میکند که الگوهای موجود در «چرخه عمر» (Life Cycle) مشتری را شناسایی کنند، به جای اینکه همه مشتریان را بدون در نظر گرفتن این مسئله تحلیل کنند که آنّا در کجای پروسه قرار دارند.

تحلیل رگرسیون در تحلیل داده چیست ؟

این روش به تحلیلگران امکان میدهد تا دریابند که کدامیک از متغیرها بر مجموعه دادههای مورد نظر تأثیر میگذارند. این قابلیت به تحلیلگران کمک میکند تا با اطمینان بتوانند تشخیص دهند که کدام عوامل ضروری هستند و کدامیک را میتوان نادیده گرفت و اینکه چگونه عوامل مشخص، بر یکدیگر تأثیر میگذارند.

برای مثال، ۲ متغیر «قد» و «سن» را در نظر بگیرید، این متغیرها معمولاً با هم افزایش پیدا میکنند. تحلیلگران به دنبال این نوع روابط علت و معمولی در دادهها هستند، زیرا با فهمیدن تاثیر عاملی بر دیگری، اتفاقات بعدی را بهتر میتوان پیشبینی کرد.

شبکه عصبی در تحلیل داده چیست ؟

شبکههای عصبی که در «یادگیری ماشین» (Machine Learning) و «یادگیری عمیق» (Deep Learning)، مورد استفاده قرار میگیرند، مجموعهای از الگوریتمهایی هستند که عملکرد مربوط به نورونهای موجود در مغز انسان را شبیهسازی میکنند. هر یک از این نورونها، ویژگیهایی دارند که در ادامه فهرست شدهاند.

- دادهها را از لایه ورودی دریافت میکند.

- داده را با انجام محاسباتی روی آن، پردازش میکند.

- دادههای پردازش شده را به نورون دیگر منتقل میکند.

نحوه حرکت دادهها ما بین نورونها در شبکه و محاسبات انجام شده، به یافتههای دادهای بستگی دارد که در طول مسیر کشف میشوند . اگرچه شبکه عصبی، خود تصمیم میگیرد که با دادهها چه کند، اما لازم است در ابتدا با دادههای ورودی آموزش ببیند.

تحلیل سری زمانی در تحلیل داده چیست ؟

این روش، شامل تحلیل دنبالهای از نقاط دادهای جمع آوری شده، در یک بازه زمانی میشود. در تحلیل «سِری زمانی» (Time series)، تحلیلگران نقاط داده را در فواصل زمانی ثابت (و نه به صورت متناوب یا تصادفی)، در دوره زمانی مشخص، ثبت میکنند.

این روش بهتر از روشهای دیگر است، زیرا میتواند نحوه تغییر متغیرها را در طول زمان نشان دهد. زمان از این بابت حائز اهمیت است که بیانگر چگونگی تکامل دادهها در طول چرخه عمر خود خواهد بود، به جای اینکه فقط شاهد نتیجه نهایی باشیم.

تکنیک تحلیل داده های کمّی چیست؟

در این قسمت، مجموعهای از بهترین روشهای توصیه شده برای درک دادههای کمّی، بیان شده است که در ادامه آنها را مرور میکنیم.

- پیش از اقدام به تحلیل داده، لازم است تا دادههای خام را به منظور وجود «ناهنجاریها» (Anomalies) بررسی کنیم.

- محاسبات مهم، مانند ارزیابی ستونهای دادهای که فرمول محور هستند (مقادیر آنها با استفاده از فرمول ایجاد شدهاند) را مجدد انجام دهیم.

- مطمئن شویم که «مجموع کل»، با مجموعِ حاصلجمعهای فرعی مطابقت داشته باشند.

- روابط بین اعدادی که باید از الگویی ثابت پیروی کنند، مانند «نسبتها در طول زمان» (Ratios over Time) را بررسی کنیم.

- اعداد را به منظور مقایسه آسانتر، نرمالسازی یا «همتراز» (Normalize) کنیم. به عنوان مثال، میتوان مواردی همچون تحلیل مقادیر به ازای هر فرد، یا نسبت به تولید ناخالص داخلی، یا مقدار شاخص، نسبت به سال پایه، را در نظر گرفت.

- با تجزیه و تحلیل عواملی که نتایجی را به دنبال خواهند داشت، مسائل را به اجزای کوچکتر تقسیم کنیم.

تحلیلگران، معمولا «آمار توصیفی»، مانند «میانگین» (Average)، «میانه» (Median) و «انحراف معیار» (Standard Deviation) را برای متغیرهای مورد بررسی بهدست میآورند. آنها همچنین ممکن است «توزیع»ِ (Distribution) متغیرهای کلیدی را تحلیل کنند، تا ببینند چگونه مقادیر منفرد، حول میانگین جمع میشوند.

کارشناسانِ شرکت «مکینزی اند کامپنی»، روشی را تحت عنوان «اصل MECE»، نامگذاری کردند که مسئله کمّی را به اجزای سازنده آن میشِکند. به این ترتیب، هر لایه را میتوان به اجزای آن تقسیم کرد. هر یک از اجزای فرعی باید نسبت به یکدیگر «دو به دو ناسازگار» (Mutual Exclusivity) باشند و باید با هم (مجموعاً) به لایه بالاییشان اضافه شوند. این رابطه، «دو به دو ناسازگار و تجمعی کامل» (Mutually Exclusive and Collectively Exhaustive | MECE) نامیده میشود.

به عنوان مثال، سود بر مبنای تعریف را میتوان به «درآمد کل» و «هزینه کل» تجزیه کرد. به همین ترتیب، «درآمد کلی» نیز میتواند به مولفههای سازندهاش، مانند درآمد بخشهای B ،A و C (که دو به دو ناسازگارند یا متقابلاً از یکدیگر جدا هستند) تجزیه شود که میبایست به «درآمد کل» افزوده شوند (تجمعی کامل).

تحلیلگران و کارشناسانِ این حوزه میتوانند از «روشهای آماری قوی» برای پرداختن یا حل مسائل تحلیلی خاص استفاده کنند. «آزمون فرضیه» (Hypothesis Testing) زمانی استفاده میشود که فرضیهای خاص در مورد وضعیت واقعی (State of Affairs) توسط تحلیلگر ساخته شود و دادهها برای تعیین «درست» (True) یا «نادرست» (False) بودن آن حالت، جمعآوری شوند.

برای مثال، فرضیه «بیکاری بر تورم تاثیر نمیگذارد» را در نظر بگیرید (که به مفهومی اقتصادی به نام منحنی فیلیپس مربوط میشود). آزمون فرضیه در این مورد، شامل در نظر گرفتن احتمال وقوع خطاهای «نوع اول» و «نوع دوم»، در پذیرش یا رد فرضیه بر مبنای دادهها است.

«تحلیل رگرسیونی» (Regression Analysis)، زمانی مورد استفاده قرار میگیرد که تحلیلگر، در تلاش است تا میزان تاثیر «متغیر مستقل X» بر «متغیر وابسته Y» را تعیین کند (به عنوان مثال، پرسش میتواند این باشد که «تغییرات در «نرخ بیکاری» (X) تا چه اندازه بر «نرخ تورم» (Y) تاثیر میگذارد». هدف در اینجا پیدا کردن فرمولی است که نشان دهد چگونه Y با X (از طریق نگاشت آنها روی منحنی) ارتباط دارد.

برای تعیین میزان تأثیر «متغیر مستقل X» بر «متغیر Y» میتوان از «تحلیل شرط لازم» (Necessary Condition Analysis | NCA) استفاده کرد. به عنوان مثال، «برای پاسخ به این پرسش که «نرخ بیکاری معین (X)» تا چه اندازه بر «نرخ تورم (Y)» تأثیر میگذارد». تحلیل رگرسیون، از «منطق افزایشی» استفاده میکند و در آن هر متغیر X میتواند نتیجهای را تولید کند، یعنی Xها میتوانند یکدیگر را تعدیل (جبران) کنند (به بیان دیگر، کافی هستند اما لازم نیستند).

در مقابل، NCA، روشی است که از منطق «لزوم» استفاده میکند. این بدان معنا است که وجود یک یا چند متغیر X برای ایجاد نتیجه ضرورت دارد، اما ممکن است منجر به نتیجهای نشود (Xها لازم هستند اما کافی نیستند). به بیان ساده، هر یک از شرایط «لازم» باید وجود داشته باشد و جبران آن توسط عوامل دیگر وجود ندارد.

ابزارهای مورد استفاده در تحلیل داده چیست ؟

در این بخش از مطلبِ «تحلیل داده چیست»، برخی از ابزارهای مفید در زمینه «تحلیل داده» که توسط متخصصان و تحلیلگران مورد استفاده قرار میگیرند، یعنی ابزارهایی مانند مایکروسافت اکسل، زبان پایتون و کتابخانههای مربوط به تحلیل داده در آن، پاور بیآی و MiniTabb میپردازیم. ابتدا در ادامه به نقش و اهمیت زبان برنامه نویسی پایتون در تحلیل داده اشاره شده است.

کاربرد پایتون در تحلیل داده چیست ؟

یکی از مهمترین دلایلی که تحلیل داده با استفاده از زبان برنامهنویسی پایتون، به روشی محبوب و رایج تبدیل شده، این است که طیف وسیعی از کتابخانههای مرتبط را برای ما فراهم میکند. در ادامه با برخی از این کتابخانهها آشنا میشویم.

- Numpy: کتابخانهای که از آرایههای n-بُعدی پشتیبانی میکند و ابزارهایی را برای «محاسبات عددی» (Numerical Computing) ارائه میدهد. Numpy همچنین برای محاسبات جبرخطی و تبدیل فوریه نیز مفید است.

- پانداس (Pandas): این کتابخانه توابعی را برای مدیریت «دادههای گمشده» (Missing Data)، انجام عملیات ریاضی و «دستکاری کردن» (Manipulate) دادهها فراهم میکند.

- Matplotlib: این کتابخانه، بهطور معمول برای ترسیم نقاط دادهای و مصورسازیِ تعاملیِ دادهها استفاده میشود.

- SciPy: کتابخانهای است که در زمینه محاسبات علمی کاربرد دارد. این کتابخانه همچنین، ماژولهایی را برای بهینهسازی، جبر خطی، میانگینگیری، توابع ویژه، پردازش تصویر و سیگنال، نیز شامل میشود.

- Scikit-Learn: این کتابخانه دارای ویژگیهایی است که به ما امکان ساخت مدلهای رگرسیون، «طبقهبندی» (Classification) و «خوشهبندی» (Clustering) را میدهد.

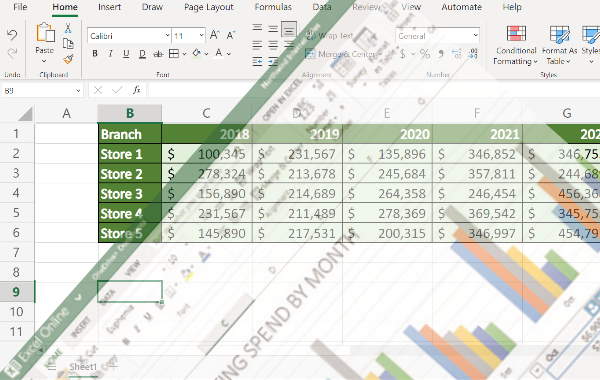

کاربرد مایکروسافت اکسل در تحلیل داده چیست ؟

اگر به دنبال ابزاری برای تجزیه و تحلیل و مصورسازی دادههای خود هستید، اکسل از مجموعه مایکروسافت آفیس، گزینه مناسبی برای این کار محسوب میشود. این برنامه در حال حاضر بخشی از زندگی روزمره افراد زیادی را تشکیل میدهد و توسط مشاغلِ کوچک، شرکتها، موسسات مالی و دولتها، اشخاص و غیره مورد استفاده قرار میگیرد.

دلایل متعددی وجود دارد که علت محبوبیت اِکسل را بیان میکند. مواردی همچون، سهولتِ در استفاده، تطبیقپذیری آن در برنامههای تحلیل دادهها و اینکه واقعاً قدرتمند و در عین حال مقرون به صرفه است. در ادامه پنج دلیل را که نشان میدهد که چرا Excel برای تحلیل داده گزینه مطلوبی است را با هم مرور میکنیم.

- Excel بیش از ۴۰۰ تابع دارد که میتوان از آن برای انجام کارهای روزمره مانند محاسبه مجموع محدودهای از سلولها یا محاسابه میانگین و سایر موارد استفاده کرد. خیلی از نیازهای ما با استفاده از همین توابع، برطرف میشود.

- اِکسل تحلیل دادهها را با بکارگیری جداول محوری (Pivot Tables) ساده میسازد. جداول محوری در Excel، راهکاری عالی برای خلاصه کردن و تحلیل حجم زیادی از دادهها محسوب میشوند. این جداول برای تجزیه و تحلیل دادهها مفید هستند، زیرا میتوانند انواع مختلف دادهها را تفسیر و کاوش کنند. همچنین، میتوانید از این قابلیت برای مصورسازی روابط بین جنبههای مختلف دادههای خود استفاده کنید. به عنوان مثال، این نوع از جداول میتوانند به تحلیل روند فروش یا پیشبینی عملکرد آینده، بر اساس الگوهای مبتنی بر تاریخ، کمک کنند.

- نیاز به سطح دانش بالایی ندارد و یادگیری آن آسان است. برخلاف برخی دیگر از برنامهها، که ما را ملزم به تهیه دورههای گران قیمت و استخدام برنامهنویس میکنند، اکسل با داشتن ویژگیهای بصری است کار را برای همه آسان کرده است. Excel همچنین بخشی از مجموعه مایکروسافت آفیس (به همراه Word و PowerPoint) است، بنابراین با سایر برنامهها به خوبی کار میکند.

- اِکسل راههای متنوعی را برای مصورسازی دادهها در اختیامان قرار میدهد. این برنامه شامل انواع مختلفی از نمودارها است که میتواند به ما کمک کند تا روایت و داستان دادههای خود را ببینیم و به اشتراک بگذاریم. همچنین میتوانیم از بین نمودارهای دوبُعدی و سهبُعدی موجود، مورد دلخواه را برگزینیم و آن را مطابق با نیازهای خود سفارشیسازی کنیم (برای این منظور، هر نمودار گزینههایی را فراهم کرده است تا با آن ظاهر و رنگهایی که مورد استفاده قرار داده است را تنظیم کنیم).

- ماکروها (Macros) و افزونههای اِکسل، قابلیتهای آن را گسترش میدهد. ماکرو شامل دستوراتی است که به منظور خودکارسازی عمل موردنظر مورد استفاده قرار میگیرد. در حالیکه «افزونه»، ویژگیهایی اضافی را به Excel اضافه میکند. برای مثال، میتوانید از ماکرو برای خودکارسازی کارهای تکراری، همچون وارد کردن دادهها در سلولها یا قالببندی متن درون سلولها استفاده کرد. افزونه هم میتواند بدون کدنویسی، داشبوردهایی تعاملی، حاوی نمودارها و جداولی را ایجاد کند که اطلاعات آن بهصورت «زنده» (live) بهروز میشود.

کاربرد پاوربیآی در تحلیل داده چیست ؟

«پاوِر بی آی» Power BI، محصول دیگری از کمپانی مایکروسافت و ابزاری پیشرو در تحلیل دادهها، هوش تجاری و گزارشدهی است که بهطور وسیع توسط متخصصان این حوزه، مورد استفاده قرار میگیرد. این ابزار، «دانشمندانِ داده» (Data Scientist) و تحلیلگران را قادر میسازد تا مجموعه دادهها را به داشبوردها، تصاویر و گزارشهای تعاملیِ جذاب و معنادار تبدیل کنند و آنها را در نظارتِ روندِ استراتژیهای کسب و کار خود، مورد استفاده قرار دهند. «Power BI»، کارِ تحلیلگران را ساده و اتصال، تبدیل و مصورسازی داده را آسان میکند.

استفاده از پاوربیآی، به همراه محصول دیگر مایکروسافت در این حوزه، یعنی اکسل، کار متداولی است. در ادامه به بیان دلایلی میپردازیم که چرا شرکتها و متخصصان، Power BI را به عنوان ابزاری برای تحلیل داده، انتخاب میکنند.

- «اتصال دادهها» (Data Connection): به عنوان یکی از بزرگترین مزایای Power BI، شامل توانایی آن در اتصال به چندین پایگاه داده جدولی میشود. این بدان معنی است که میتواند با بسیاری از ابزارها و سیستمهای شرکتی کار کند تا «وارد کردن» (Importing) و «صدور» (Exporting) داده، داشبوردها و گزارشها را تا حد امکان سادهتر و سریعتر سازد.

- «مصورسازی دادهها» (Data Visualization): پاور بیآی یکی از کاملترین پلتفرمها برای مصورسازی دادهها به حساب میآید. در این برنامه، قالبهای زیادی را خواهید دید که توسط مایکروسافت تایید شدهاند، در حالیکه میتوانید تصویر سفارشی خود را نیز ایجاد کنید.

- «تحلیل پیشرفته»: پاوربیآی، ابزاری مطلوب برای بهبود تحلیل دادههای Excel با استفاده از تجزیه و تحلیل پیشرفتهتر است. میتوانید دادههای کسب و کار را با جذب، تبدیل و یکپارچهسازیِ خدمات دادهای به سایر ابزارهای مایکروسافت، بهبود ببخشید.

- «مدیریت داده»: برای هر فردی که با دادهها کار میکند، مدیریت آن برای اطمینان از اجرای روان هر نوع فرایند، به ویژه در محیط کسب و کار، ضروری است. زیرا سازمانها اغلب دارای حجم زیادی از دادهها هستند که وقتی به خوبی سازماندهی نشده باشند، میتوانند تمام ارزش خود را از دست بدهند.

- «کاوش در دادهها»: Power BI شامل گزینههای زیادی برای کاوش داده و همچنین پرسوجوهای خودکار است. با این ابزار، کشف بینش از دادهها بسیار آسانتر خواهد بود. همچنین بستر ایدهآلی برای کار با متدلوژی «بالا به پایین» (Top-Down) است.

- UI و UX: پاوربیآی، به عنوان ابزاری سازمانی، برای استفاده کاربران تجاری، طراحی شده است. بنابراین، کاربران اصلی آن، تحلیلگران داده و مشاوران هوش تجاری هستند. با این وجود، مفهوم تجاری پلتفرم، آن را به یکی از ابزارهای «هوش تجاری» با بهترین قابلیت استفاده و رابط کاربری، تبدیل میکند. علاوه بر این، با Power BI میتوانیم گزارشهای خود را با تصویر برند (لوگو) خود تطبیق دهیم و این فرایند را با طراحی قالبهایی که میتوانند بر روی همه گزارشهایمان اعمال شوند، بهصورت خودکار درآوریم.

کاربرد MiniTab در تحلیل داده چیست ؟

مینیتب، بستهای نرمافزاری برای تحلیل داده، آمار و بهبود فرایند است. این نرمافزار توسط سازمانهای بسیاری در سراسر جهان، برای بهبود کیفیت و کاهش هزینهها، مورد استفاده قرار میگیرد. Minitab، بهطور گستردهای در صنایع مختلف از جمله مراقبتهای بهداشتی، تولیدی و آموزشی استفاده میشود.

از نمونه ابزارهایی که مینیتب (برای انجام تحلیلهای آماری) در اختیار کاربران قرار میدهد، میتوان به «آزمون فرضیه»، «تحلیل رگرسیون» و غیره اشاره کرد. علاوه بر این، Minitab ابزارهای گرافیکیِ گوناگونی را برای کمک به کاربران، با هدف مصورسازی دادهها فراهم میکند. در ادامه برخی از مزایای مینی تب بیان شده است.

- یادگیری و استفاده آسان

- تواناییِ تحلیل آماری قوی

- قابلیتِ مدیریت «مجموعه دادههای بزرگ»

- فراهم نمودن مواردی جامع، در بصریسازی دادهها

- گزینههای صدور و گزارشدهی انعطافپذیر

تفاوت های Data Analytics و Data Analysis چیست ؟

یکی از تصورات رایج و اشتباهی که وجود دارد این است که گاهی اوقات این دو فرایند به عنوان مفهومی مشابه در نظر گرفته میشوند یا حتی بهجای یکدیگر بهکار میروند. نکته جالب اینجاست که گاهی اوقات این اصطلاحات توسط «دانشمندان داده» و خود «تحلیلگرانِ داده» نیز اشتباه گرفته میشوند.

در این مطلب که به تشریح پرسش «تحلیل داده چیست» پرداخته شده است، اصطلاح «تحلیل داده» به عنوان برگردان فارسیِ «Data Analysis» و عبارت «فراکاوش | فراکافتِ داده» بهجای «Data Analytics» استفاده شده است. اما تفاوتی که میتوان برای آنها قائل شد، شامل مواردی است که در ادامه بیان میشود.

- فراکاوش داده، حوزه وسیعی، شامل استفاده از دادهها و ابزارها با هدفِ تصمیمگیریهای تجاری را شامل میشود.

- تحلیل داده، زیرمجموعهای از «فراکاوشِ داده» است که به اَعمال و اقدامات خاصی اشاره دارد که در این باره انجام میشود.

برای پرهیز از سردرگمی و روشن شدن موضوع، مروری بر هر دوی این اصطلاحات و همینطور، مثالها و ابزارهای مورد استفاده در هر کدام خواهیم داشت.

فراکاوش داده چیست؟

«فراکاوش داده»، اصطلاح گستردهای است که مفهوم و عملِ (شاید هم علم و هنر) تمام اقدامات و فعالیتهای مرتبط با دادهها را در بر میگیرد. هدف اصلی، این است که «کارشناسان داده» (Data Experts)، از جمله دانشمندان داده، مهندسان و تحلیلگران، دسترسی و درک این یافتهها را برای بقیه کسب و کارها، آسان کنند.

دادههای خام، به خودیِ خود، ارزش خاصی ندارند و این استفاده ما از دادهها است که ارزشی را خلق میکند. فراکاوش داده، تمام مراحلی را شامل میشود که برای کشف، تفسیر، تجسم و بیان داستان الگوهای موجود در دادههایمان، به منظور پیشبرد استراتژی کسب و کار و نتایج آن، انجام میدهیم. حال ممکن است این مراحل توسط افراد یا با کمک ماشینها انجام شود.

فراکاوشگر دادهِ مطلوب، باید بتواند تا استراتژی بهتری برای هدایت کسب و کارِ شما ارائه دهد. وقتی این کار به درستی انجام شود، تجزیه و تحلیل دادهها میتواند به مواردی کمک کند که در ادامه ذکر شدهاند.

- یافتن روندها یا «گرایشها» (Trends)

- کشف فرصتها

- پیشبینی اقدامات، «محرکها» (Triggers) و رویدادها

- تصمیمگیری

تجزیه و تحلیل دادهها، قاعدهمند است و شامل بسیاری از مراحل محاسباتی و مدیریتی میشود. کارشناسان بر «قاعدهمند» (Systematic) بودن آن تاکید ویژهای دارند. سیستماتیک بودن بسیار حیاتی است، زیرا فراکاوش داده اقدامات مختلفی را بهکار میگیرد و از منابع دادهای با هر نوع و هر اندازهای استفاده میکند.

بسیاری از حوزههای موضوعی از جمله «علم داده» (Data Science)، «یادگیری ماشین» (Machine Learning) و «آمار کاربردی» (Applied Statistics)، فراکاوش داده را شامل میشوند.

از نتایج ملموسی که تحلیل دادهها، بهدنبال دارد، میتوان، به گزارشهایی اشاره کرد که بهدرستی برنامهریزی شدهاند (مفید هستند) و «مصورسازی» (Visualization) دادهها را برای بیان نقاط مهم بهکار گرفتهاند تا بقیه کسبوکار (که متخصص داده نیستند) بتوانند آنها را درک کنند، توسعه دهند و همچنین استراتژیهای خود را با آن وفق دهند.

راههای زیادی وجود دارد که فراکاوش داده میتواند از طریق آن، زمینههای فرصت را در مورد کسب و کار، به ما نشان دهد.

- استفاده از حقایق (و نه حدس و گُمان) برای درک نحوه تعامل مشتریهایمان، ممکن است به این معنی باشد که فرایندهای فروش یا بازاریابی خود را بایستی تغییر بدهیم. بهطور مثال، یک نانوایی ممکن است با تحلیل دادههای خود، متوجه شود که تقاضا برای نان حجیم در زمستان افزایش مییابد، در نتیجه، این معنی از آن استنباط میشود که وقتی تقاضا زیاد است، نیازی نیست قیمتهای خود را کاهش دهد.

- افزایش حملات سایبری، ممکن به این معنی باشد که باید اقدامات پیشگیرانهای را بهکار ببندیم.

- دادههای بهدست آمده از «دستگاههای اینترنت اشیا» (IoT Devices) که در مکانی خاص مانند اتاق سرور، ایستگاه برق یا انبار، قرار دارند، میتوانند نشان دهند که آیا ایمنی و قابلیت اطمینان مورد نیازمان را با کمترین هزینه ممکن فراهم کردهایم یا خیر.

فرایندهای موجود در فراکاوش داده چیست؟

عمل فراکاوش داده، بسیاری از فرایندهای جدا از هم (گسسته) را در بر میگیرد که میتواند «خطِ لولهای دادهای» (Data Pipeline) را شامل شود. در ادامه در این باره بیشتر توضیح میدهیم.

- جمعآوری و جذب دادهها

- دستهبندی دادهها به اَشکال ساختاریافته یا بدون ساختار، که ممکن است اقدامات بعدی را نیز تعریف کند.

- مدیریت دادهها، که معمولا در پایگاه دادهها، Data Lakeها، Data Warehousها انجام میشود.

- ذخیرهسازی دادهها در Cold Storage یا Warm Storage

- اجرای ETL (استخراج، تبدیل، بارگذاری)

- تحلیل دادهها برای استخراج الگوها، گرایشها و بینشها

- بهاشتراکگذاری دادهها با کاربران تجاری یا مصرفکنندگان که معمولا از طریق داشبورد یا از طریق فضای ذخیرهسازی خاصی صورت میگیرد.

تحلیل داده چیست ؟

«تحلیل داده» (Data Analysis)، زیر مجموعهای از «فراکاوش داده» محسوب میشود. تحلیل داده، مراحلی همچون «تمیز کردن» (Cleaning)، «تبدیل» (Transforming)، «مدلسازی» (Modeling) و تفحص دادهها به منظور یافتن اطلاعات را در بر میگیرد. بهطورکلی در این مورد توافق شده است که بخشهای دیگر، از جمعآوری تا ذخیرهسازی و مصورسازی، عملیات دیگری محسوب میشوند.

عملِ تحلیل داده، معمولاً محدود به «مجموعهدادهای» (Dataset) «از پیش آماده شده» است. بهاین صورت که دادهها را «بررسی» (Inspect) میکنیم، «نظم» (Arrange) میدهیم و آنها را زیر سوال میبریم. امروزه، اولین مرحله از Analysis بهوسیله نرمافزار یا «ماشین» و اغلب بهطور مستقیم در یکی از پایگاهدادهها یا ابزارها، انجام میشود. این فرایند توسط عامل انسانی تقویت میشود که دادهها را با پیشزمینه بیشتری بررسی و تحقیق میکند.

وقتی «تحلیلِ» (Analyzing) مجموعهدادهای را به پایان رساندیم، به سراغ سایر اقدامات لازم برای فراکاوش دادهها خواهیم رفت. در ادامه، برخی از این اقدامات، آورده شدهاند.

- این امکان را فراهم میکنیم تا دیگران به دادهها دسترسی داشته باشند.

- دادهها را به روشی مطلوب، مانند مصورسازی یا روایتپردازی، ارائه میدهیم.

- با توجه به دادهها، اقداماتی را به منظور «اجرا» پیشنهاد میدهیم.

نکته کلیدی در مورد تحلیل داده، این است که دادهها را از قبل جمعآوری میکند.

تحلیل یا فراکاوش کدام یکی بهتر است؟

نتیجه «فراکاوش داده»، فراگیرتر و سودمندتر از «تحلیل» به تنهایی است. برخی از تفاوتها، در ادامه بیان شده است.

- فرد تحلیلگر (Analyst) که «صفحه گستردهای» از اعداد را برای کاربر تجاری ارسال میکند در مقابل ساخت داشبوردی برای کاربر، تا با فراکاوش توصیفی، تعامل داشته باشد.

- کاربر تجاری، گزارشی با مقادیر «زنده» کمپین بازاریابی دریافت میکند در مقابل ایجاد برنامه وبی که هم پیشبینی را نشان میدهد و هم به کاربر اجازه میدهد با فراکاوشِ پیشگویانه تعامل داشته باشد.

هدف نهایی این است که محصولی را تولید کنیم تا به منظور اینکه اقدامی در این راستا صورت گیرد، عملِ پیشبینی را بر مبنای دادهها انجام دهد و از طریق API با سیستم دیگر ارتباط برقرار کند. تحلیلهای تکرارپذیر، اغلب میتوانند به معیاری جدید در پلتفرم فراکاوش ما تبدیل شوند.

ابزارهای فراکاوش داده ها کدام اند؟

نرمافزارهای فراکاوش، ابزارهایی هستند که به ما کمک میکنند تا تحلیلهایی را با هدف کمک به اتخادِ تصمیمهای تجاری، انجام دهیم.

ابزارهای رایج برای انجام تحلیل داده و فراکاوش کلی، در ادامه بیان شده است.

- مایکروسافت اِکسل

- مایکروسافت Power BI

- Tableau

- R آنالیتیکز

- پایتون

- ابزار تحلیلی گوگل (Google Analytics)

سوالات پر تکرار

در ادامه، برخی از سوالات متداول که ممکن است در ذهن شما پیرامون مفهوم تحلیل داده وجود داشته باشند را به همراه پاسخ آنها، با هم مرور میکنیم.

تفاوت بین دانشمند داده و تحلیل گر داده چیست؟

بهطور خلاصه میتوان گفت که تحلیلگران داده سوالات موجود در مورد دادهها را حل و فصل میکنند. همچنین راهحلهایی را ایجاد میکنند که میتواند توسط سایر ذینفعان مورد استفاده قرار گیرد، در حالیکه دانشمندان داده سیستمهایی را برای خودکارسازی و بهینهسازی عملکرد کلی کسب و کار میسازند.

یکی از تفاوتهای کلیدی بین دانشمندان داده و تحلیلگران داده در این است که «آنها با دادهها چه میکنند» و «چه نتایجی را به دست میآورند». تحلیلگر داده به دنبال پاسخ به سؤالات خاص یا رفع چالشهایی است که قبلاً شناسایی و برای کسب و کار مورد نظر، شناخته شدهاند.

برای انجام این کار، آنها مجموعه دادههای بزرگ را با هدف شناسایی روندها و الگوها، بررسی میکنند. سپس یافتههای خود را در قالب نمودارها، اَشکال و داشبوردها به تصویر میکشند. این تصویرها با سهامداران کلیدی به اشتراک گذاشته میشوند و برای اتخاذ تصمیمات استراتژیک مبتنی بر داده، مورد استفاده قرار میگیرند.

از سوی دیگر، دانشمند داده، سوالهایی را که کسب و کار، باید (یا میتواند) بپرسد، مدنظر قرار میدهد. آنها فرایندهای جدیدی را برای مدلسازی دادهها طراحی میکنند، الگوریتمهایی را مینویسند، مدلهایی را برای پیشبینی طراحی میکنند و همچنین تحلیلهای سفارشی را میسازند.

به عنوان مثال، آنها ممکن است سیستمی را بسازند که با بهکارگیری مجموعهداده، اقدامات مشخصی را بر اساس دادهها و بهصورت خودکار انجام دهد و با نظارت و آزمایش مداوم همراه باشد و همچنین با ظهور الگوها و روندهای جدید، آن سیستم را تا جایی که ممکن است بهبود میدهند و بهینه میکنند.

انواع مختلف تحلیل داده چیست؟

از انواع مختلف تحلیل داده میتوان مواردی مانند تحلیل پیشگویانه، تحلیل تشخیصی، تحلیل تجویزی، تحلیل آماری و تحلیل متنی را نام برد.

در دنیای واقعی، چه نمونههایی از تحلیل داده وجود دارد؟

یکی از نمونههای به کارگیری تحلیل داده در دنیای واقعی «خدمات درمانی» و مراقبتهای بهداشتی است. تحلیل داده در این زمینه تا حد زیادی مؤثر عمل میکند. به عنوان مثال، محققی از دانشگاه دلاوِیر، سیستمی را تولید کرد که با استفاده از دستگاه تنفسی مجهز به تکنولوژی بلوتوث و همچنین الگوریتمی منحصر به فرد برای تحلیل داده، به بیماران آسم، در مدیریت بهتر وضعیت خود کمک میکند.

مورد دیگری که میتوان نام برد، وبگاه نتفلیکس و توصیههای شخصیسازی شده آن به کاربران است. در این زمینه سعی بر این است که محتوای ویدیویی که احتمالا مورد پسند کاربر واقع میشود، به وی توصیه شود.

فرایند تحلیل داده شامل چه مواردی است؟

پنج مرحله اصلی که تحلیلگر داده، هنگام انجام پروژهای جدید انجام میدهد، شامل تعریف پرسشهایی که باید پاسخی را برای آنها پیدا کرد، جمعآوری دادهها، پاکسازی دادهها، تحلیل دادهها، مصورسازی و به اشتراگ گذاشتن نتایج میشود.

ابزارها و تکنیک های مورد استفاده در تحلیل داده چیست ؟

تحلیلگران، طیف وسیعی از تکنیکها، از جمله تحلیل رگرسیونی، تحلیل عامل (یا کاهش بُعد)، تحلیل Cohort، تحلیل خوشهای و تحلیل سری زمانی را به کار میگیرند و از ابزارهایی مانند مایکروسافت اِکسل، Tableau، رَپیدماینر، Power BI و غیره استفاده میکنند.

مهارت های لازم برای تبدیل شدن به تحلیل گر داده چیست؟

برای تبدیل شدن به تحلیلگر داده موفق، به مهارتهای سخت و نرم، از جمله تواناییهای ریاضی و آماری، آشنایی با زبانهای برنامهنویسی مانند پایتون، اوراکل و SQL و غیره، داشتن ذهنی تحلیلگر، مشتاق و داشتن مهارت کافی در حل مسئله و همچنین مهارتهای ارتباطی عالی، اشاره کرد.

جمعبندی

از آنجا که دادهها با سرعت زیادی در حال رشد هستند و در هر دقیقه به حجم آنها افزوده میشود، مشاغل، راهحلهایی را جستجو میکنند که با استفاده از آن، معانی و بینش ارزشمندی را از این دادهها بیرون بکشند، با این هدف که موفقیتی در کسب و کار خود بهدست آورند و در نتیجه، سود خود را افزایش دهند. پس میتوان گفت که تحلیل داده، حوزهای در حال رشد است و تحلیلگر داده ماهر، در صنایع گوناگون همچنان مورد تقاضا است.

با آموزش صحیح، هر کسی که اشتیاق و اراده پا گذاشتن در این مسیر را داشته باشد، میتواند به تحلیلگر دادهای کاملاً حرفهای و آماده برای بازار کار تبدیل شود. در این مطلب از مجلهی تم آف و در پاسخ به این سوال که «تحلیل داده چیست»، سعی کردیم که اطلاعات مفیدی را پوشش دهیم. اگر در این حوزه تازه وارد هستید، آموختن همه مهارتهای لازم برای تحلیلگر داده شدن، ممکن است وقت و انرژی زیادی را از شما بگیرد، اما مهم این است که اجازه ندهید که چیزی شما را نا امید کند.